Las herramientas de gestión de calidad

Cuando hablamos de calidad de un producto, debemos saber lo que entiende y espera el destinatario de lo que le ofrecemos. Si preguntamos a diversos compradores, puede que nos digan que los productos comprados son de gran calidad, aunque uno de ellos sea mucho más caro y tenga mayores prestaciones. Si esto es así, probablemente obedece a que todos los compradores han obtenido las prestaciones que esperaban. El cumplimiento de los requisitos esperados, la percepción del cliente de haberlos conseguido, y haber superado sus expectativas, son los objetivos (targets)que toda organización debe conseguir. El uso de herramientas de la gestión de la calidad, utilizando técnicas estadísticas, puede ayudar a conseguirlo.

Introducción

A lo largo de los años, se han ido implan-tando herramientas, métodos, instruc-ciones para mejorar la calidad interna del producto (inspección, control de calidad, aseguramiento de la calidad, enfoque a procesos, gestión total de la calidad, etc.); es decir, una organización mediante el uso de diversas herramientas analiza e implanta acciones encaminadas a elimi-nar los costes de no calidad, y por lo tanto, para mejorar su producto.

Se puede considerar, a grandes rasgos, que la evolución de los sistemas de calidad han seguido las siguientes fases:

1.ª Etapa: Control de calidad de producto terminado (rechazado/aceptado).

2.ª Etapa: Control de aseguramiento de la producción.

3ª Etapa: Control de productos comprados (inspección en recepción).

4.ª Etapa: Aseguramiento del sistema de calidad (factor humano).

5.ª Etapa: Gestión del sistema de calidad (satisfacción del cliente).

6.ª Etapa: Gestión de la calidad total (orientación a la calidad total).

Cualquier organización debe tender hacia la gestión de la calidad total, es decir, debe estar orientada al cliente (tanto interno, como externo).

Ahora bien, entender los requisitos del cliente y sus expectativas (anticipar-nos a lo no especificado, pero deseado por éste) no es fácil, y su no consecución nos trae gastos en garantías, reparacio-nes, pérdida de su fidelidad, costes inter-nos de planificación y productos inter-nos asociados, etc.

Según J.M. Juran, para llegar a la etapa de gestión de calidad total, «se debe implantar en la empresa la cultura de cos-tes de no calidad, e implicación de la organización en dicha gestión.»

Pero ¿qué es la calidad?

Recordemos, antes de continuar, los siguientes conceptos de calidad:

Grado en el que un conjunto de carac-terísticas (rasgo diferenciador) cumple con los requisitos (necesidad o expecta-tiva establecida, generalmente implíci-ta u obligatoria) (ISO 9000:2005, © AENOR 2005).

Otros conceptos (Calidad, Salvador Oliva, 1999, Ed. ITP-Paraninfo):

J.M. Juran: «idoneidad o aptitud para el uso» es lo que percibe el cliente, bueno o malo. Philip B. Crosby:

«cumplimiento de unas especificaciones o la conformidad de unos requisitos», planificar en todas las etapas de producción para asegurar la conformidad.

W.E.Deming:

«grado predecible de uniformidad y fiabilidad a bajo costo y adecuado a las necesidades del mercado» (se consigue si hay baja variabilidad de las características del producto).

Geinichi Taguchi

«la pérdida mínima para la sociedad en la vida del producto conlleva que con una mayor calidad no se aumentan los costes asociados.»

Ahora bien, hay aspectos en los cua-les no es posible, o es muy difícil, cuan-tificar los costes asociados al incumpli-miento de las expectativas del cliente (entrega en un plazo no deseado aun-que menor del especificado, mal trato comercial, mala relación laboral con los empleados en materia de seguridad la-boral, producto poco respetuoso con el medio ambiente, etc.).

Conceptos de estadísitica

Cuando calibramos un equipo o ins-peccionamos lotes, utilizamos muestras. En las técnicas de muestreo, se persi-gue como objetivo analizar estadística-mente las propiedades de una población a partir del estudio de muestras repre-sentativas de todo el conjunto. La extra-polación de las conclusiones obtenidas para las muestras a toda la población se denomina inferencia estadística.

(http://www.hiru.com/matematika/matematika_06500.html)

Por lo tanto, cuando las mediciones realizadas en una población determinada tienen naturaleza estocástica (no deter-minista), las técnicas estadísticas han sido utilizadas por las organizaciones como herramienta para entender y analizar la variabilidad de los datos obtenidos, y así para la ayuda en la toma de las decisio-nes. La variabilidad de una medida se puede cuantificar cuando se asocia a un conjunto de datos de una población (con-junto de personas, tornillos, etc.) deter-minada, de tamaño N (número de ele-mentos que tiene la población).

Las variables estadísiticas asociadas a fenómenos aleatorios se pueden clasifi-car en variables cualitativas (describe cua-lidades de un objeto) y cuantitativas (se utilizan unidades de medida). Estas últi-mas se pueden dividir, a su vez, en varia-bles aleatorias discretas y variables ale-atorias continuas.

Recordemos que una variable aleato-ria (v.a.) X es una función de un experi-mento estadístico con la que se obtienen valores reales (xi∈R) de un espacio mues-tral determinado (S). El espacio S es un subconjunto de R. Se puede decir que la probabilidad de que la v.a. X tome el valor x, como P(X=x) y se representa como p(x).

Por ejemplo, número de tornillos defectuosos en un lote, número de bac-terias por centímetro cuadrado, etc., son variables aleatorias discretas. Las mag-nitudes físicas, la presión de un émbolo, el voltaje de una batería, etc., son v.a. con-tínuas

Dos de los términos que más se uti-lizan cuando tenemos una función de densidad de probabilidad, p(x) son la esperanza matemática o media (E(X) o μ) y la varianza (Var(X)) y/o desviación típica (σ) (la varianza es igual al cuadrado de la desviación típica).

La esperanza matemática es una medida de la posición (el valor medio) que toman los valores de una variable, y la varianza es una medida de la disper-sión de los valores de dicha variable con respecto a la media.

Podemos ver un ejemplo: suponga-mos que en una fábrica que inspeccionan por lotes, deducen que la probabilidad de que el producto sea defectuoso es del 0,2. Si suponemos que el coste de pro-ducción son 12 y la venta del producto es de 17, el valor esperado del beneficio será el siguiente: Si la v.a. es X= Benefi-cio esperado, cuya P(X) = 0,8; la espe-ranza matemática E(X) = X * P(X) = 5 * 0,8 + (-12) * 0,2 = 1,6.

Luego considerando las pérdidas en producción, tenemos que el beneficio por unidad es de 1,6.

(Probabilidad y Estadísitica, Elisa Pardo Ruiz, Servicio Editorial de la UPV).

Técnicas estadísiticas

Podemos citar entre otras Técnicas para orientar a la organización a la gestión de la calidad total (la cultura de la calidad en toda la organización o cliente interno) las siete herramientas básicas (histogra-mas, diagramas de dispersión, diagrama de causa-efecto, etc.), SPC (control esta-dística de procesos), DOE, AMFE, tor-menta de ideas, despliegue de la función de calidad (QFD), gestión del conoci-miento, mejora continua, etc.

En cuanto a las técnicas estadísticas en particular, su utilización puede abar-car toda la vida del producto (desde su planificación y desarrollo hasta su dis-posición final) ayudando a descubrir y prevenir problemas que mejoren la efi-cacia y la eficiencia en los procesos de una organización.

Los requisitos del cliente y la percepción por parte del cliente de haberlos conseguido, así como los de la organiza-ción de haberlos alcanzado, son concep-tos diferentes a la hora de afrontar la con-secución de un producto/servicio de calidad (apartado 2.10, UNE EN ISO 9000:2005, © AENOR 2005).

Otras técnicas estadísticas aplicables en los sistemas de gestión de calidad son los siguientes (UNE ISO/TR 10017, Orientación sobre las técnicas estadísti-cas para la norma ISO 9001:2000, © AENOR 2004.):

1. Estadísticas descriptivas:

Procedimientos para resumir y pre-sentar datos cuantitativos de manera que revelen las características de la distribu-ción de los datos. Ejemplo: Gráfico de dispersión de datos para evaluar la rela-ción entre dos variables; histogramas, etc.

Suministran información acerca de un producto, proceso (por ejemplo el tiempo y temperatura de un horno).

2. Diseño de experimentos:

Investigaciones realizadas de forma planificada para alcanzar un nivel de con-fianza establecido, evaluando estadísti-camente los resultados. El objetivo con-siste en validar alguna característica de un producto, proceso o sistema, o inves-tigar la influencia que uno o más facto-res afectan a un producto, proceso o sis-tema. Los hallazgos obtenidos se pueden utilizar como elementos de entrada para el desarrollo o diseño de un producto o proceso, o para controlar o mejorar uno existente.

3. Prueba de hipótesis:

Si partimos de una muestra (conjunto de datos), debemos decidir si, a raíz de los valores obtenidos de esa muestra, es compatible con una hipótesis dada con respecto a un modelo o parámetro esta-dístico. Es decir, si la hipótesis de un nuevo modelo o procedimiento estadís-tico debería ser rechazado, o no.

Un ejemplo de esto sería comprobar si de los datos obtenidos de una pobla-ción determinada la distribución de esta población es normal.

4. Análisis de regresión:

El análisis de regresión se utiliza para predecir los resultados de un experi-mento. Se consigue analizar la variación de la respuesta de un proceso en función de las variables que lo producen.

Por ejemplo, en modelos de regresión no lineal podríamos predecir el volumen de una concentración (variable de respuesta), al someterla a una presión determinada (variable explicativa).

5. Gráficos de control:

Gráfico de datos derivados de mues-tras que se extraen periódicamente de un proceso. Su función se describe para detectar cambios en un proceso. Se dis-tingue por definirse los «límites de con-trol» y así identificar si algún punto sale de esos límites, y así hacer ajustes y mejo-rar los procesos.

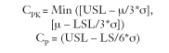

En el control estadístico de proce-sos, SPC (método utilizado en el cual una variable aleatoria cuantitativa, cuya función de densidad de probabilidad p(x) sigue una distribución normal (ej.: longitud de un tornillo en una línea de producción), es medida en diferentes lotes, y así detectar las variaciones que afectan a la calidad del producto o ser-vicio. Se identifican el valor límite superior (USL) y valor límite infe-rior (LSL), para acotar el intervalo de tolerancia de una especificación de un producto (es decir, si el 99,8% de las observaciones están dentro del inter-valo de aceptación de la especificación del producto). Para saber si un proceso es fiable y está bajo control, y si la variable cumple con las especificacio-nes determinadas, se utilizan los índi-ces de capacidad de proceso CPK y/o CP; donde:

donde μ es el valor medio de las medi-ciones, y σ la desviación típica.

(http://www.isixsigma.com)

6. Análisis de la medición:

Conjunto de procedimientos para evaluar la incertidumbre de sistemas de medición en el rango de condiciones en los que se trabaja. Un ejemplo sería el de la determinación de la incertidumbre de la medición

La desviación típica, es utilizada para calcular la incertidumbre asociada en los equipos de medición (se utiliza normal-mente la incertidumbre expandida de medida, U= κ*U(y), que se calcula mul-tiplicando la incertidumbre típica u(y) de la estimación de salida y por un factor de cobertura κ.

Cuando se puede atribuir una distribución normal (gausiana) al mensurando y la incertidumbre típica asociada a la estimación de salida tiene la suficiente fiabilidad, debe utilizarse.

Si el factor de cobertura es κ = 2, la incertidumbre expandida asociada corres-ponde a una probabilidad de cobertura de, aproximadamente, un 95%. Estas condiciones se cumplen en la mayoría de los casos encontrados en los trabajos de calibración de equipos de medición. (Expresión de la incertidumbre de medida en las calibraciones; CEA-ENAC-LC/02; Rev. 1 Enero 98).

La función de pérdida

En los años ochenta, Taguchi definió la calidad como la pérdida que un producto experimenta cuando se expide a la socie-dad, es decir, mientras más calidad tenga un producto menor será la pérdida. Esta definición nos recuerda lo que hoy se conoce como responsabilidad social de las empresas (Libro Verde, fomentar un marco europeo para la responsabili-dad social de las empresas, Comisión de las Comunidades Europeas). La fun-ción de pérdida de Taguchi cuantifica los costes de un producto que es liberado en la sociedad.

La función se expresa de la siguiente manera:

L(x) = k*(x-T)2

donde k es una constante dependiente de la característica a considerar, y T, el valor medio objetivo. A medida que nos alejamos de ese valor objetivo, mayor pérdida, según dicha función cuadrática.

La función de pérdida viene a decir lo siguiente:

Supongamos un estado θ que repre-senta un estado de la naturaleza que no responde a las leyes deterministas, por lo que tan sólo podemos conocer una serie de características mediante una serie de experimentos que nos darán información sobre ese estado.

Donde X (v.a. continua), (x, x, x3,…

Es decir, lo que nosotros podemos saber de ese estado lo realizaremos mediante la elección de un sistema de medición d(X), función de decisión. La elección de una función de decisión determinada genera pérdida, por lo que la función de pérdida será:

F(θ, d[X]) = L(X)

La elección de una función de decisión está asociada a una función de pérdida. De todas las decisiones posibles, habrá una que nos genere una función de pérdida menor (menor error, menor coste), que tenga un riesgo menor.

Diseño de experimentos

Otro de los conceptos en los que trabajó Taguchi, fue el diseño de experimentos. Esta técnica de gestión hacia la calidad total fue desarrollada en los años 20 por Sir Ronald A. Fisher en Inglaterra. Se fundamenta en realizar experimentos, introduciendo variables (señal de ruido), que asemejen condiciones reales de fun-cionamiento, que lleve a diseños robus-tos, es decir, productos que, sometidos a diversas variables o ruidos (variaciones de temperatura, deterioro, etc.), se con-sigue que no manifiesten altas variabi-lidades. Por lo tanto, se deben analizar las variables que influyen en un proceso determinado en el que se produzca o se vaya a producir un problema o error, y analizar el resultado. Volviendo a la fun-ción de pérdida antes referenciada L(x)= k*(x-T)2, identificaremos qué variables influyen más en la variabilidad (disper-sión) del output, centrando el resultado en la media; es decir, que minimice k*(x-T)2; y a su vez aumentar las tolerancias de las variables que no influyen o más bien poco en el resultado final, y así reducir costes (TQM, ASI Edición).

Entropía de la información

En 1948, Claude E. Shannon en su tra-bajo «A Mathematical Theory of Com-munication» («Una teoría matemática de la comunicación») desarrolló la teoría de la información en la computación científica, y dedujo la siguiente fórmula:

H(X) = -k*P(Xi)*log(P[Xi])

Cuyo significado, a grandes rasgos, sería el máximo nivel de codificación de datos de un mensaje entre un emisor y un receptor determinado. A la función H(X) se la conoce como entropía de la información.

Las propiedades más importantes son:

1. Si H(X) = 0, entonces es cuando P(Xi) = 1(certeza de configuración o de estado)

2. Si H(X) es máx., cuando P(Xi) = 1/n (estados equiprobables)(máxima interteza o falta de información).

(Orden y caos en sistemas complejos, Ricard V. Solé – Susana C. Manrubia, Edicions UPC).

El concepto de entropía ha ido ligado desde mediados del siglo XX a varias ramas de la ciencia y tecnología, aparte de la ter-modinámica (biología, geología, ciencias sociales, incluso la economía [Física, teo–ría de la información y economía: Tres lugares comunes para la entropía. José Luis Cuenca Tadeo]). (Metodología de los Siste–mas de producción para criptografiado óptimo, Tesis Doctoral, Vicente Martínez Orga). Aunque no todos han compartido esta visión globadizadora (entropía negativa como conocimiento, etc.) (Entropía, hacia el Mundo Invernadero, Jeremy Riffkin. Epí-logo de Nicolás Georgescu-Roegen).

Luego podríamos considerar que, si tenemos una variable aleatoria X: Pro-ducto con la calidad esperada, y sabemos que tenemos una P(X) = 0,95 (95%), la entropía será casi nula, ya que nos aporta bastante información: sabemos que un 95% de nuestros clientes están satisfe-chos con el producto recibido. En cam-bio, si P(X) = 0,5, H(X) es máxima, estado de máxima incertidumbre.

En una organización, lo que se busca es obtener información del entorno (cliente, sociedad, usuario, etc.), y la fun-ción H(X) viene a especificar que, mien-tras mayor sea ésta, menor información tenemos y, por lo tanto, menor capaci-dad en las decisiones y eficiencia en las actuaciones posteriores.

Asimismo, es importante analizar el flujo de obtención de dicha informa-ción, identificar las variables aleatorias que consideremos necesarias para cono-cer si cumplimos los requisitos y expec-tativas del cliente, y analizar las rela-ciones entre ellas (información mutua). Al carecer de información, no tenemos certeza de haber alcanzado su cumpli-miento.

Un método para obtener información sobre los procesos de una empresa sería conocer la entropía condicionada de una variable X, conocida Y, para así decidir entre varias una serie de variables Y1, Y2, …, y así decidir cuál de ellas aporta más información a la variable X, por ser la que minimiza H(X/Yi). Un ejemplo de esto sería el estado del tiempo: conociendo el de hoy, podemos predecir con más exac-titud el de mañana, con lo que la función H(X/Yi) se minimiza. (Orden y caos en sis–temas complejos, Ricard V. Solé – Susana

C. Manrubia, Edicions UPC).

Bibliografía

Oliva, Salvador (1999). Calidad, Ed. ITP-Paraninfo.

Libro Verde, Fomentar un marco europeo para la responsabilidad social de las empresas. Comisión de las Comunidades Europeas.

Elisa Pardo Ruiz. Probabilidad y Estadística, ©Servicio Editorial de la UPV.

José Luis Cuenca Tadeo. Física, teoría de la información y economía: Tres lugares comunes para la entropía.

Ricard V. Solé y Susana C. Manrubia. Orden y Caos en sistemas complejos, Edicions UPC.

TQM, ASI Edición. Metodología de los Sistemas de producción para criptografiado óptimo (Tesis Doctoral, Vicente Martínez Orga, UPM.)

Expresión de la incertidumbre de medida en las calibraciones; CEA-ENAC-LC/02; Rev. 1 Enero 98

UNE en ISO 9000:2005, © AENOR 2005

UNE ISO/TR 10017, Orientación sobre las técnicas estadísticas para la norma ISO 9001: 2000, © AENOR 2004.

Jeremy Riffkin (1990). Entropía, hacia el Mundo Invernadero, Editorial Urano. http://www.hiru.com/matematika/matematika_06500.html

http://www.ine.es

http://www.isixsigma.com